Révolutionner l'analytique d'entreprise : Réduction des coûts avec les produits de données

À mesure que la demande de données augmente, l'accès aux meilleures données pour soutenir la prise de décision basée sur les données devient une dépense importante. Les méthodes de déplacement et d'accès aux données développées avant la prolifération de l'informatique et du stockage dans le cloud ont désormais du mal à évoluer efficacement pour suivre le rythme.

Les technologies d'accès aux données existantes n'ont pas été conçues pour gérer la capacité de connexion permanente et en temps réel du cloud. Avant le cloud, les données devaient être stockées à proximité de l'application pour pouvoir être analysées. Même avec la nature en temps réel du cloud, la manière fondamentale dont les données sont déplacées, fusionnées et préparées pour l'analyse n'a pas changé de manière significative. Ce manque d'adaptabilité entrave la vitesse d'analyse et néglige les possibilités de réduire les coûts d'infrastructure et d'ingénierie des données.

Dans l’analyse suivante, nous examinerons les coûts d’accès aux données de manière traditionnelle à l’aide d’ETL (Extract, Transform, Load) et les comparerons aux approches innovantes utilisant des données fédérées qui exploitent les puissantes capacités du cloud.

Coûts ETL

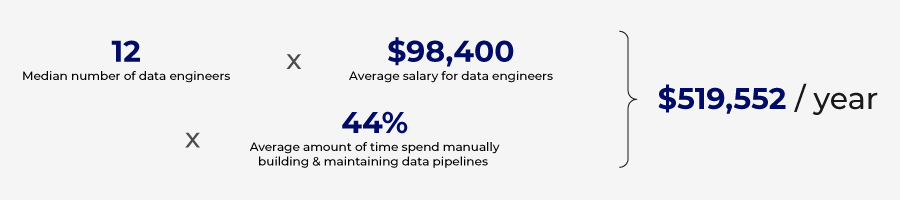

Il est difficile de calculer le coût exact de la création de pipelines ETL, mais nous pouvons estimer ces coûts en évaluant les données accessibles au public et en faisant certaines hypothèses.

Créer un pipeline ETL à partir de zéro

La création d'un pipeline ETL nécessite un investissement important en temps et en ressources. Bien que plusieurs ressources soient nécessaires pour créer un pipeline ETL à partir de zéro, un ingénieur de données effectue la majeure partie du travail. Ce professionnel hautement qualifié programme manuellement les scripts pour extraire les données, les transformer pour les analyser et les charger dans la base de données cible. Selon Glassdoor, le salaire moyen d'un ingénieur de données aux États-Unis dépasse 150 000 dollars par an ; si l'on considère le coût total des avantages et des dépenses en ETP, cela coûte 195 000 dollars par an, soit 95 dollars de l'heure.

Les estimations montrent que la création d'un pipeline ETL rudimentaire prend entre une et trois semaines. Supposons que l'effort moyen soit de 80 heures pour construire un pipeline ETL, ce qui équivaut à 7 600 $ par pipeline. De plus, ces pipelines nécessitent une maintenance, qui peut nécessiter 20 % de l'effort initial chaque année, soit 1 520 $ supplémentaires par an. La construction de pipelines ETL plus complexes peut prendre des mois, voire des années, et coûter des centaines de milliers de dollars. La simple création et le test d'un connecteur de données peuvent prendre six semaines et demie.

Une enquête menée par Wakefield Research estime que les organisations dépensent 520 000 $ par an pour créer et maintenir des pipelines de données.

Plateforme ETL sans code

Le codage et la gestion des pipelines ETL à partir de zéro peuvent être coûteux, mais il existe des outils qui peuvent rationaliser le processus et automatiser certaines des exigences de codage. Des pipelines ETL moins complexes peuvent être créés à l'aide de plateformes sans code.

Ces plateformes exploitent l'automatisation et l'IA pour réduire le temps et les compétences nécessaires à la création de pipelines ETL. En exploitant certains des outils actuellement disponibles, les pipelines ETL peuvent être créés en seulement trois jours.

Bien que ces plateformes puissent réduire les besoins en ressources nécessaires à la création manuelle de pipelines, elles ont un coût. En général, ces solutions sont basées sur le volume de données et le nombre de bases de données connectées à la plateforme. Pour les grandes entreprises, ces coûts augmentent rapidement et de nombreux cas d'utilisation en périphérie peuvent ne pas être pris en charge par la solution sans code.

Le nombre de pipelines va augmenter à mesure que le coût de création de pipelines ETL avec des solutions sans code diminue considérablement. Cette prolifération de pipelines ETL crée un nouveau problème : la duplication des données et l'augmentation des coûts de stockage.

Coûts de stockage

Les stratégies de stockage se déclinent en différentes configurations et architectures, ce qui rend les estimations de stockage précises assez complexes. Cependant, sur la base de données accessibles au public, nous pouvons quantifier les coûts associés au stockage et à la gestion des données dupliquées créées par les stratégies ETL.

Chaque fois qu'un ensemble de données est extrait d'un système et chargé dans un autre, un ensemble de données en double est créé et doit être stocké. Plus il y a de pipelines et de demandes de données, plus il y a d'ensembles de données en double créés, ce qui augmente les coûts de stockage.

La croissance du big data et le mouvement prolifique des données ont entraîné une augmentation des données redondantes, obsolètes et triviales (ROT) conservées dans les magasins de données. Statista rapporte que 8 % de toutes les données détenues par les entreprises sont originales et 91 % sont répliquées. Veritas Technologies a mené une étude similaire et a découvert que 16 % des données sont critiques pour l'entreprise, 30 % sont des données redondantes, obsolètes et triviales (ROT) et 54 % sont des données obscures, dont la valeur est inconnue. Les deux études arrivent à une conclusion similaire : une quantité écrasante de données inutiles est conservée par les entreprises, ce qui entraîne un gaspillage important de ressources pour stocker ces données inutiles.

Si l'on considère que Google Cloud facture 0,02 $ par Go et par mois pour le stockage dans le cloud, cela représente 20 $ par téraoctet et 20 000 $ par pétaoctet. Selon Veritas Technologies, une entreprise moyenne dépense 650 000 $ par an pour stocker des données non critiques.

Plusieurs facteurs sont à l'origine de la croissance du ROT, le maintien de silos de données étant un facteur important. Chaque fonction de l'entreprise gère sa propre base de données pour prendre en charge chaque opération, ce qui conduit à la répétition d'ensembles de données communs dans plusieurs de ces bases de données, gaspillant ainsi des ressources de stockage.

Données erronées causées par ROT

Coût de la gouvernance

Le stockage des données ROT a non seulement des répercussions sur les coûts de stockage, mais augmente également les risques. La multiplication des copies d'un même ensemble de données conduit à des sources de vérité contradictoires, et des formats de données variés entraînent une confusion.

Pour éviter une mauvaise qualité des données, des politiques efficaces de gouvernance des données doivent être mises en œuvre. En 2021, Gartner a estimé que la mauvaise qualité des données coûte aux organisations en moyenne 12,9 millions de dollars par an.

Les processus manuels traditionnels de gouvernance des données ne suffisent plus et des investissements dans des outils et des stratégies automatisés de gouvernance des données sont nécessaires. La vérification manuelle des rapports et la configuration de règles personnalisées prennent du temps. La mise en œuvre de ces politiques, règles et supervisions de manière indépendante pour chaque pipeline ETL nécessite une attention particulière et un investissement en temps.

Investir dans la prévention des données erronées est de l’argent bien dépensé. Si cela coûte un dollar pour prévenir les données erronées, cela coûtera 10 dollars pour les corriger et 100 dollars en cas d’échec. LeData Warehousing Institute estime que les données erronées coûtent aux entreprises 600 milliards de dollars par an.

Les données redondantes présentent également des risques pour la confidentialité. Une grande partie des données répliquées dans les silos de données incluent des données PII (informations personnelles identifiables). Cette approche augmente la probabilité d'une violation de données.

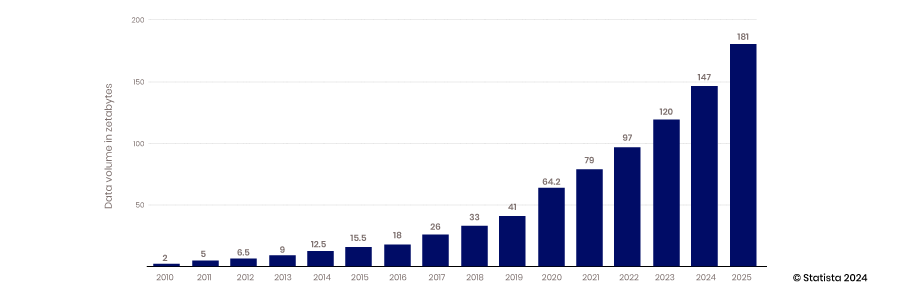

Les défis ne feront que s'accroître

La croissance exponentielle continue de la collecte et du stockage des données ne fera qu'aggraver les problèmes de duplication des données créés par des stratégies d'intégration et de gestion inefficaces des données. Statista estime que d'ici 2025, 181 zettaoctets seront créés, consommés, copiés et capturés.

Coûts indirects

Compte tenu du temps nécessaire pour développer des pipelines ETL à partir de zéro ou en utilisant des plateformes sans code, l'accès aux données n'est pas aussi agile qu'il pourrait l'être. Des opportunités sont perdues lorsque les analystes et les décideurs ne peuvent pas accéder rapidement à des données de qualité. Ces coûts d'opportunité sont difficiles à quantifier, mais sont bien réels. Compte tenu du nombre de décisions prises au sein d'une organisation, il est important d'augmenter le temps nécessaire pour obtenir des informations, même de manière marginale. En optimisant la prise de décision au sein d'une organisation, les économies de coûts d'opportunité s'accumulent, car de bonnes décisions conduisent à des décisions et des options encore meilleures.

Nouveau paradigme

Une nouvelle approche ou un nouveau paradigme d'accès aux données émerge, qui réduira les coûts d'accès et de gestion des données. Cette approche s'éloigne de l'ETL et se concentre sur la gouvernance centrale, la sécurité et l'accès autour des produits de données. (Pour approfondir le nouveau paradigme des données, assurez-vous de lire cet article de blog)

Cette nouvelle approche permet d'accéder aux données sans avoir à les déplacer ou à les répliquer. Cette stratégie s'appuie également sur des produits de données réutilisables qui éliminent la nécessité de créer des pipelines ETL pour chaque cas d'utilisation. Ce changement peut entraîner des économies de temps de 40 à 50 % pour la mise à disposition de données en libre-service, ce qui représente une économie de 4 100 $ par pipeline individuel, ou de 225 000 $ pour une organisation type qui dépense des ressources sur des pipelines ETL.

Le déplacement des données d'une base de données vers une autre via un processus ETL étant éliminé, les coûts de stockage sont réduits. En l'absence de données redondantes créées à partir des pipelines ETL, les coûts de stockage et de préparation peuvent être réduits de 30 à 40 %.

Réduire les coûts

Ce nouveau paradigme exploite les produits de données pour fournir des données aux plateformes d’analyse, réduisant ainsi les efforts et les coûts nécessaires à la création de ces produits de données par rapport aux pipelines de données. Leur création prend moins de temps et nécessite des compétences moins coûteuses. Il faut environ 24 heures pour créer un produit de données, soit 70 % de moins que pour créer un pipeline ETL rudimentaire. En outre, le travail peut être effectué par un analyste de données plutôt que par un ingénieur de données. Les salaires des analystes de données aux États-Unis s’élèvent en moyenne à 77 000 $, soit un coût ETP total de 100 000 $. Ce coût équivaut à 50 $ de l’heure contre 96 $ pour un ingénieur de données. En faisant le calcul sur la base de ces estimations, le coût de création d’un produit de données est de 1 200 $ contre 7 600 $ pour un seul pipeline de données simple.

La nouvelle approche des produits de données réduit la demande de stockage de données, mais l'accès en temps réel aux données augmente les coûts de traitement du réseau et des bases de données. Bien qu'il y ait un compromis, les coûts de mise en réseau ne sont encourus que lorsque des données précieuses sont fournies pour analyse, contrairement aux coûts de stockage qui sont encourus pour stocker des données inutiles et inutilisées.

Les progrès de l'automatisation de la gouvernance des données permettent également de réaliser des économies de coûts importantes dans le paysage actuel de la gestion des données. La gouvernance automatisée comprend l'automatisation de la classification des données, du contrôle d'accès, de la gestion des métadonnées et du suivi de la lignée des données. Les solutions de gouvernance des données permettent aux organisations de tirer parti des algorithmes et des flux de travail pour automatiser l'application des politiques de données, surveiller l'utilisation des données et résoudre les problèmes de qualité des données avant qu'ils ne deviennent un problème. Informatica estime que les organisations peuvent économiser entre 475 000 et 712 000 dollars grâce à des solutions de gouvernance automatisées.

En règle générale, ces solutions sont des packages autonomes intégrés à vos pipelines de données, coûtant environ 20 000 $ par an pour 25 utilisateurs. L'approche de la plateforme de produits de données place la gouvernance au centre du processus et est incluse dans le coût de la plateforme.

Des économies propulsées par des produits de données

En règle générale, les pipelines ETL sont conçus pour un cas d'utilisation spécifique, les avantages qu'ils offrent devant compenser les coûts de leur création, ce qui rend leur valeur relativement bien comprise et statique. L'adaptabilité des produits de données rend leur valeur plus évolutive. Avec des produits de données construits sur une plate-forme standard, plusieurs produits de données peuvent être facilement combinés pour créer de nouveaux produits de données. En outre, un produit de données spécifique peut être destiné à un cas d'utilisation particulier, mais peut facilement être adapté à une autre opportunité pour ajouter de la valeur dans une application distincte.

Cette adaptabilité permet aux produits de données d'augmenter leur valeur, car ils peuvent répondre à de nouveaux cas d'utilisation que le développeur d'origine n'avait peut-être pas envisagés. À mesure que la valeur augmente et que le coût de création de ce produit de données reste stagnant, le retour sur cet investissement augmente. C'est une autre façon dont les produits de données contribuent à réduire les coûts pour offrir de nouvelles perspectives et de la valeur.

Il existe de nombreuses façons de réduire les coûts grâce à une stratégie de produits de données, permettant une meilleure prise de décision et une meilleure formation de l'IA. Si la stratégie de produits de données contribue à réduire les coûts, le véritable avantage est lié à une agilité et une compétitivité accrues. Cet avantage est cumulatif et non quantifiable, mais bien réel.

Pas encore partenaire Concierto ?

Take the leap from data to AI