Rivoluzionare l'analisi aziendale: Ridurre i costi con i prodotti di dati

Con l'aumento della domanda di dati, ottenere l'accesso ai dati migliori per supportare il processo decisionale basato sui dati sta diventando una spesa significativa. I metodi per spostare e accedere ai dati sviluppati prima della proliferazione dell'elaborazione e dell'archiviazione nel cloud, ora faticano a scalare in modo efficiente per tenere il passo.

Le tecnologie di accesso ai dati legacy non sono state progettate per gestire la capacità sempre attiva e connessa in tempo reale del cloud. Prima del cloud, i dati dovevano essere archiviati vicino all'applicazione per poter essere analizzati. Anche con la natura in tempo reale del cloud, il modo fondamentale in cui i dati vengono spostati, uniti e preparati per l'analisi non è cambiato in modo significativo. Questa mancanza di adattabilità ostacola la velocità di analisi e trascura le opportunità di ridurre i costi di infrastruttura e di ingegneria dei dati.

Nella seguente analisi prenderemo in considerazione i costi dell'accesso ai dati nel modo tradizionale tramite ETL (Extract, Transform, Load) e li confronteremo con approcci innovativi che utilizzano dati federati e sfruttano le potenti funzionalità del cloud.

Costi ETL

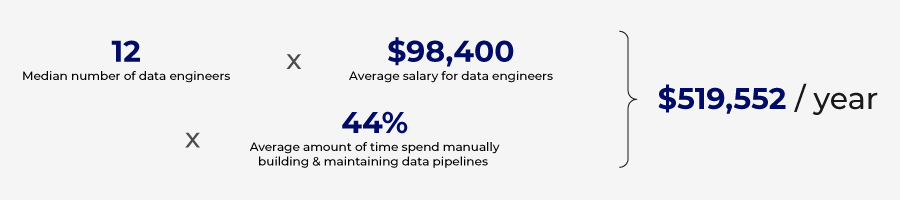

Calcolare il costo esatto della creazione di pipeline ETL è difficile, ma possiamo stimare tali costi valutando i dati disponibili al pubblico e formulando alcune ipotesi.

Costruire una pipeline ETL da zero

Creare una pipeline ETL richiede un investimento significativo di tempo e risorse. Mentre sono necessarie più risorse per creare una pipeline ETL da zero, un data engineer esegue la maggior parte del lavoro. Questo professionista altamente qualificato programma manualmente gli script per estrarre i dati, trasformarli per l'analisi e caricarli nel database di destinazione. Secondo Glassdoor, lo stipendio medio di un data engineer negli Stati Uniti supera i 150.000 $ all'anno; se si considera il costo totale FTE di benefit e spese, ciò costa 195.000 $ all'anno o 95 $ all'ora.

Le stime mostrano che la creazione di una pipeline ETL rudimentale richiede da una a tre settimane. Supponiamo di supporre che lo sforzo medio sia di 80 ore per costruire una pipeline ETL, il che equivale a $ 7.600 per pipeline. Inoltre, queste pipeline richiedono manutenzione, che potrebbe richiedere il 20% dello sforzo originale ogni anno o $ 1520 aggiuntivi all'anno. Le pipeline ETL più complesse possono richiedere mesi o persino anni per essere costruite, con un costo di centinaia di migliaia di dollari. La semplice costruzione e il test di un connettore dati possono richiedere sei settimane e mezza.

Un sondaggio condotto da Wakefield Research ha stimato che le organizzazioni spendono 520.000 dollari all'anno per creare e gestire pipeline di dati.

Piattaforma ETL senza codice

La codifica e la gestione delle pipeline ETL da zero possono essere costose, ma ci sono strumenti che possono semplificare il processo e automatizzare alcuni dei requisiti di codifica. Le pipeline ETL meno complesse possono essere costruite utilizzando piattaforme senza codice.

Queste piattaforme sfruttano l'automazione e l'intelligenza artificiale per ridurre il tempo e le competenze richieste per creare pipeline ETL. Sfruttando alcuni degli strumenti attualmente disponibili, le pipeline ETL possono essere create in appena tre giorni.

Sebbene queste piattaforme possano ridurre il fabbisogno di risorse per creare manualmente le pipeline, hanno un costo. In genere, queste soluzioni si basano sul volume di dati e sul numero di database connessi alla piattaforma. Per le aziende più grandi, questi costi aumentano rapidamente e molti casi d'uso edge potrebbero non essere supportati dalla soluzione no-code.

Il numero di pipeline crescerà man mano che il costo di creazione di pipeline ETL con soluzioni no-code si ridurrà in modo significativo. Questa proliferazione di pipeline ETL crea un nuovo problema: duplicazione dei dati e aumento dei costi di storage.

Costi di stoccaggio

Le strategie di storage sono disponibili in varie configurazioni e architetture, rendendo le stime precise dello storage piuttosto complesse. Tuttavia, sulla base dei dati disponibili al pubblico, possiamo quantificare i costi associati all'archiviazione e alla gestione dei dati duplicati creati dalle strategie ETL.

Ogni volta che un set di dati viene estratto da un sistema e caricato in un altro, viene creato un set di dati duplicato, che deve essere archiviato. Più pipeline e richieste di dati, più set di dati duplicati vengono creati, aumentando i costi di archiviazione.

La crescita dei big data e il prolifico movimento di dati hanno portato a un aumento dei dati ridondanti, obsoleti e banali (ROT) conservati negli archivi dati. Statista segnala che l'8% di tutti i dati detenuti dalle aziende è originale e il 91% è replicato. Veritas Technologies ha eseguito un progetto di ricerca simile e ha scoperto che il 16% dei dati è business critical, il 30% è Redundant Obsolete Trivial (ROT) e il 54% è dark data, in cui il valore dei dati è sconosciuto. Entrambi gli studi giungono a una conclusione simile: una quantità enorme di dati inutili viene mantenuta dalle aziende, il che porta a notevoli sprechi di risorse nell'archiviazione di ciò che è dati inutili.

Se si considera che Google Cloud addebita 0,02 $ per GB al mese per l'archiviazione cloud, ciò equivale a 20 $ per terabyte e 20.000 $ per petabyte. Secondo Veritas Technologies, l'organizzazione media spende 650.000 $ all'anno per archiviare dati non critici.

Diversi fattori stanno guidando la crescita di ROT, con la manutenzione dei silos di dati che è un fattore determinante. Con ogni funzione aziendale che mantiene il proprio database per supportare ogni operazione, si verifica che set di dati comuni vengano ripetuti in molti di questi database, sprecando così risorse di storage.

Dati errati causati da ROT

Costo della governance

L'archiviazione di ROT non solo ha implicazioni sui costi di archiviazione, ma aumenta anche il rischio. Copie multiple dello stesso set di dati portano a fonti di verità contrastanti e vari formati di dati portano a confusione.

Per evitare una scarsa qualità dei dati, è necessario implementare efficaci policy di governance dei dati. Nel 2021, Gartner ha stimato che una scarsa qualità dei dati costa alle organizzazioni una media di 12,9 milioni di dollari all'anno.

I tradizionali processi di data governance manuali non sono più sufficienti e sono necessari investimenti in strumenti e strategie di data governance automatizzati. La verifica manuale dei report e l'impostazione di regole personalizzate richiedono molto tempo. L'implementazione di queste policy, regole e supervisione in modo indipendente per ogni pipeline ETL richiede un'attenzione e un investimento di tempo molto approfonditi.

Investire nella prevenzione dei dati errati è denaro ben speso. Se costa un dollaro prevenire i dati errati, costerà 10 dollari ripararli e 100 dollari in caso di guasto. IlData Warehousing Institute afferma che i dati errati costano alle aziende 600 miliardi di dollari all'anno.

I dati ridondanti pongono anche rischi per la privacy. Gran parte dei dati replicati nei silos di dati includono dati PII (informazioni personali identificabili). Questo approccio aumenta la probabilità di una violazione dei dati.

Le sfide non faranno che aumentare

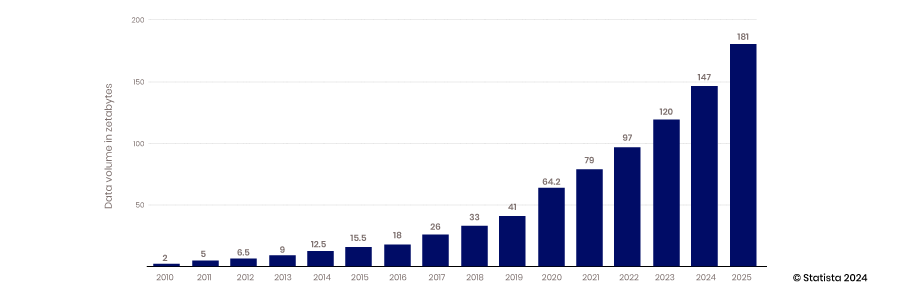

La continua crescita esponenziale della raccolta e dell'archiviazione dei dati non farà che esacerbare i problemi relativi ai dati duplicati creati da strategie di integrazione e gestione dei dati inefficienti. Statista stima che entro il 2025 saranno creati, consumati, copiati e catturati 181 zettabyte.

Costi indiretti

Con il tempo necessario per sviluppare pipeline ETL da zero o utilizzando piattaforme senza codice, l'accesso ai dati non è così agile come potrebbe essere. Le opportunità vengono perse quando analisti e decisori non riescono ad accedere rapidamente a dati di qualità. Questi costi opportunità sono difficili da quantificare, ma sono molto reali. Con il numero di decisioni prese in un'organizzazione, aumentare anche marginalmente il tempo per ottenere informazioni è significativo. Ottimizzando il processo decisionale in un'organizzazione, i risparmi sui costi opportunità si sommano poiché buone decisioni portano a decisioni e opzioni ancora migliori.

Nuovo paradigma

Sta emergendo un nuovo approccio o paradigma di accesso ai dati che ridurrà i costi di accesso e gestione dei dati. Questo approccio si allontana da ETL e si concentra sulla governance centrale, sulla sicurezza e sull'accesso ai prodotti dati. (Per approfondire il Nuovo Paradigma dei Dati, assicurati di leggere questo post del blog)

Questo nuovo approccio fornisce l'accesso ai dati senza doverli spostare o replicare. Questa strategia sfrutta anche prodotti di dati riutilizzabili che eliminano la necessità di creare pipeline ETL per ogni caso d'uso. Questo cambiamento può comportare un risparmio di tempo del 40-50% per il provisioning dei dati per il self-service, che ammonta a un risparmio di $ 4.100 per pipeline individuale o $ 225.000 per l'organizzazione tipica che spende risorse in pipeline ETL.

Poiché viene eliminata la necessità di spostare dati da un database all'altro tramite un processo ETL, i costi di archiviazione vengono ridotti. Senza dati ridondanti creati da pipeline ETL, i costi di archiviazione e preparazione possono essere ridotti del 30-40%.

Riduzione dei costi

Questo nuovo paradigma sfrutta i prodotti dati per fornire dati alle piattaforme di analisi, riducendo così lo sforzo e i costi necessari per creare questi prodotti dati rispetto alle pipeline dati. Richiedono meno tempo per la creazione e competenze meno costose. Ci vogliono circa 24 ore per creare un prodotto dati, ovvero il 70% in meno rispetto alla creazione di una pipeline ETL rudimentale. Inoltre, il lavoro può essere svolto da un analista dati anziché da un data engineer. Gli stipendi per gli analisti dati negli Stati Uniti ammontano in media a $ 77.000 o un costo FTE totale di $ 100.000. Questo costo equivale a $ 50 all'ora rispetto a $ 96 per un data engineer. Facendo i calcoli in base a queste stime, il costo per creare un prodotto dati è di $ 1200 rispetto a $ 7600 per una singola pipeline dati semplice.

Il nuovo approccio al prodotto dati riduce la domanda di archiviazione dati, ma l'accesso in tempo reale ai dati al suo posto aumenta i costi di elaborazione di rete e database. Sebbene vi sia un compromesso, i costi di rete vengono sostenuti solo quando vengono forniti dati preziosi per l'analisi, a differenza dei costi di archiviazione che vengono sostenuti archiviando dati inutili e inutilizzati.

Il progresso nell'automazione della governance dei dati determina anche notevoli risparmi sui costi nell'attuale panorama della gestione dei dati. La governance automatizzata include l'automazione della classificazione dei dati, del controllo degli accessi, della gestione dei metadati e del tracciamento della discendenza dei dati. Le soluzioni di governance dei dati consentono alle organizzazioni di sfruttare algoritmi e flussi di lavoro per automatizzare l'applicazione delle policy sui dati, monitorare l'utilizzo dei dati e affrontare i problemi di qualità dei dati prima che diventino un problema. Informatica stima che le organizzazioni possano risparmiare da $ 475.000 a $ 712.000 utilizzando soluzioni di governance automatizzate.

In genere, queste soluzioni sono pacchetti autonomi avvitati alle tue pipeline di dati, che costano circa $ 20.000 all'anno per 25 utenti. L'approccio della piattaforma di prodotti dati mette la governance al centro del processo ed è incluso nel costo della piattaforma.

Economie alimentate dai prodotti dati

In genere, le pipeline ETL sono costruite per un caso d'uso specifico, con i vantaggi che forniscono necessari per superare i costi per costruirle, rendendo il loro valore relativamente ben compreso e statico. L'adattabilità dei prodotti dati rende il loro valore più scalabile. Con prodotti dati costruiti su una piattaforma standard, più prodotti dati possono essere facilmente combinati per creare nuovi prodotti dati. Inoltre, uno specifico prodotto dati può essere destinato a un caso d'uso particolare, ma può essere facilmente adattato a un'altra opportunità per aggiungere valore in un'applicazione separata.

Questa adattabilità consente ai prodotti dati di aumentare di valore poiché possono affrontare nuovi casi d'uso che lo sviluppatore originale potrebbe non aver previsto. Man mano che il valore aumenta e il costo per creare quel prodotto dati rimane stagnante, il ritorno su quell'investimento cresce. Questo è un altro modo in cui i prodotti dati stanno aiutando a ridurre i costi per fornire nuove intuizioni e valore.

Esistono numerosi modi in cui una strategia di prodotto dati riduce i costi, consentendo un migliore processo decisionale e una migliore formazione AI. Mentre la strategia di prodotto dati aiuta a ridurre i costi, il vero vantaggio è legato a una maggiore agilità e competitività. Questo vantaggio è composto e non quantificabile, ma molto reale.

Richiedi una demo OGGI!

Take the leap from data to AI