企業分析の革命: データ製品でコスト削減

データの需要が増大するにつれ、データに基づく意思決定をサポートするために最適なデータにアクセスするためのコストが増大しています。クラウドでのコンピューティングとストレージが普及する前に開発されたデータの移動とアクセスの方法は、現在、効率的に拡張して対応することが困難になっています。

従来のデータ アクセス テクノロジーは、クラウドの常時接続のリアルタイム機能に対応するようには設計されていませんでした。クラウドが登場する前は、データを分析するにはアプリケーションの近くに保存する必要がありました。クラウドのリアルタイム性にもかかわらず、データを移動、結合、分析用に準備する基本的な方法は大きく変わっていません。この適応性の欠如により、分析の速度が低下し、インフラストラクチャとデータ エンジニアリングのコストを削減する機会を見逃してしまいます。

次の分析では、ETL (抽出、変換、ロード) を使用した従来の方法でデータにアクセスするコストを検討し、クラウドの強力な機能を活用するフェデレーション データを使用する革新的なアプローチと比較します。

ETLコスト

ETL パイプラインの作成にかかる正確なコストを計算することは困難ですが、公開されているデータを評価し、いくつかの仮定を立てることで、これらのコストを見積もることができます。

ETL パイプラインをゼロから構築する

ETL パイプラインの構築には、かなりの時間とリソースの投資が必要です。ETL パイプラインをゼロから作成するには複数のリソースが必要ですが、ほとんどの作業はデータ エンジニアが行います。この高度なスキルを持つ専門家は、スクリプトを手動でプログラムしてデータを抽出し、分析用に変換し、ターゲット データベースにロードします。Glassdoor によると、米国のデータ エンジニアの平均給与は年間 15 万ドルを超えています。福利厚生と経費の合計 FTE コストを考慮すると、年間 195,000 ドル、つまり 1 時間あたり 95 ドルのコストがかかります。

推定によると、基本的な ETL パイプラインの作成には 1 ~ 3 週間かかります。ETL パイプラインの構築に平均 80 時間かかると仮定すると、パイプライン 1 つあたり 7,600 ドルになります。さらに、これらのパイプラインにはメンテナンスが必要で、毎年元の作業量の 20% または 1,520 ドルの追加費用が必要になる可能性があります。より複雑な ETL パイプラインの構築には数か月から数年かかる場合もあり、数十万ドルの費用がかかります。データ コネクタを 1 つ構築してテストするだけでも 6 週間半かかります。

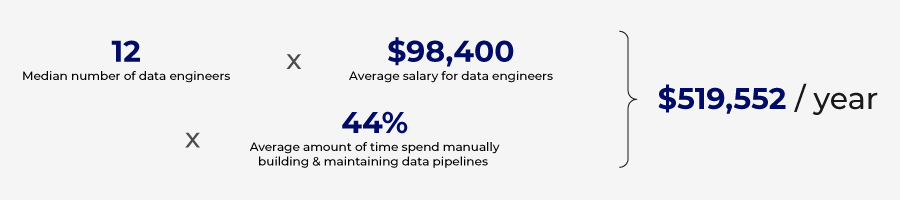

Wakefield Researchが実施した調査では、組織がデータ パイプラインの構築と維持に年間 52 万ドルを費やしていると推定されています。

コード不要のETLプラットフォーム

ETL パイプラインを最初からコーディングして管理するのはコストがかかる可能性がありますが、プロセスを合理化し、コーディング要件の一部を自動化できるツールがあります。それほど複雑でない ETL パイプラインは、コード不要のプラットフォームを使用して構築できます。

これらのプラットフォームは、自動化と AI を活用して、ETL パイプラインの構築に必要な時間とスキルセットを削減します。現在利用可能なツールのいくつかを活用することで、ETL パイプラインはわずか 3 日で作成できます。

これらのプラットフォームは、パイプラインを手動で構築するためのリソース要件を下げる可能性がありますが、コストがかかります。通常、これらのソリューションは、データ量とプラットフォームに接続されているデータベースの数に基づいています。大企業の場合、これらのコストは急速に増加し、多くのエッジユースケースはノーコードソリューションではサポートされない可能性があります。

ノーコード ソリューションによる ETL パイプラインの構築コストが大幅に削減されるにつれて、パイプラインの数は増加します。ETL パイプラインの急増により、データの重複とストレージ コストの上昇という新たな問題が発生します。

保管コスト

ストレージ戦略にはさまざまな構成とアーキテクチャがあり、正確なストレージの見積もりは非常に複雑です。しかし、公開されているデータに基づいて、ETL 戦略によって作成された重複データの保存と管理に関連するコストを定量化できます。

データセットが 1 つのシステムから抽出され、別のシステムにロードされるたびに、重複したデータ セットが作成されるため、保存する必要があります。

ビッグ データの増加とデータの移動の急増により、データ ストアに保持される冗長、古くなった、無用な (ROT) データが増加しています。Statistaの報告によると、企業が保持する全データのうち 8% がオリジナルで、91% が複製されています。Veritas Technologies も同様の調査プロジェクトを実施し、データの 16% がビジネス クリティカル、30% が冗長で古くなった無用な (ROT)、54% がデータの価値が不明なダーク データであることがわかりました。どちらの調査でも、企業が保持する無用なデータが膨大な量に上り、無用なデータを保存するために大量のリソースが浪費されているという同様の結論に達しています。

Google Cloud がクラウド ストレージに月額 1 GB あたり 0.02 ドルを請求することを考慮すると、1 テラバイトあたり 20 ドル、1 ペタバイトあたり 20,000 ドルになります。Veritas Technologies によると、平均的な組織は重要でないデータの保存に年間 650,000 ドルを費やしています。

ROT の増加には複数の要因が関係していますが、データ サイロの維持が大きな要因となっています。すべてのビジネス機能が各操作をサポートするために独自のデータベースを維持しているため、共通のデータ セットがこれらのデータベースの多くで繰り返され、ストレージ リソースが浪費されています。

ROT による不良データ

ガバナンスのコスト

ROT を保存すると、ストレージ コストがかかるだけでなく、リスクも増大します。同じデータ セットのコピーが複数あると、真実のソースが矛盾するようになり、データ形式が多様になると混乱が生じます。

データ品質の低下を回避するには、効果的なデータ ガバナンス ポリシーを実装する必要があります。2021 年にGartner は、データ品質の低下により組織が年間平均 1,290 万ドルの損失を被ると推定しました。

従来の手動データ ガバナンス プロセスではもはや十分ではなく、自動化されたデータ ガバナンス ツールと戦略への投資が必要です。手動でレポートを精査し、カスタム ルールを設定するのは時間がかかります。これらのポリシー、ルール、監視を各 ETL パイプラインに個別に実装するには、細心の注意と時間の投資が必要です。

不良データを防止するための投資は、お金を有効に活用することになります。不良データを防止するために 1 ドルかかるとすると、それを修正するには 10 ドル、障害が発生した場合には 100 ドルかかります。DataWarehousing Institute によると、不良データによって企業は年間 6,000 億ドルの損失を被っています。

冗長データはプライバシーのリスクももたらします。データ サイロ間で複製されるデータの多くには、PII データ (個人を特定できる情報) が含まれます。このアプローチでは、データ侵害の可能性が高まります。

挑戦は増えるばかり

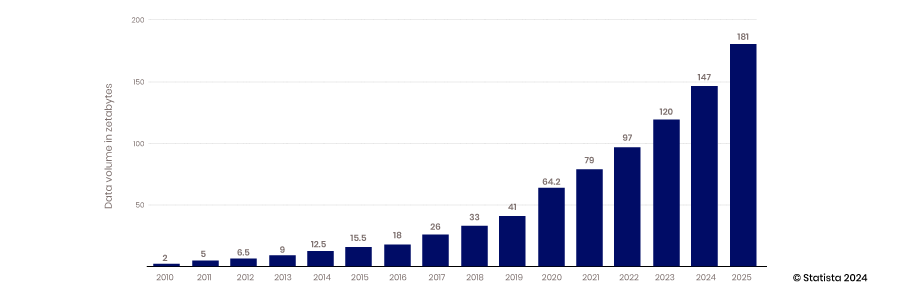

データ収集とストレージの継続的な急激な増加は、非効率的なデータ統合と管理戦略によって作成された重複データに関する問題を悪化させるだけです。Statistaは、2025 年までに 181 ゼタバイトが作成、消費、コピー、キャプチャされると予測しています。

ソフトコスト

ETL パイプラインをゼロから開発したり、ノーコード プラットフォームを使用したりするには時間がかかるため、データ アクセスは可能な限り俊敏ではありません。アナリストや意思決定者が質の高いデータに迅速にアクセスできないと、機会が失われます。これらの機会費用は定量化が難しいですが、非常に現実的です。組織全体で多数の意思決定が行われているため、洞察を得るまでの時間がわずかでも長くなると大きな意味を持ちます。組織全体で意思決定を最適化することで、良い意思決定がさらに優れた意思決定と選択肢につながるため、機会費用の節約が倍増します。

新しいパラダイム

データ アクセスと管理のコストを削減する新しいアプローチ、つまりデータ アクセス パラダイムが登場しています。このアプローチは ETL から離れ、データ製品に関する中央ガバナンス、セキュリティ、アクセスに重点を置いています。 (新しいデータ パラダイムについて詳しく知るには、このブログ投稿をお読みください)

この新しいアプローチにより、データを移動したり複製したりすることなくデータにアクセスできます。また、この戦略では再利用可能なデータ製品も活用されるため、ユースケースごとに ETL パイプラインを作成する必要がなくなります。この移行により、セルフサービス用のデータのプロビジョニングにかかる時間が 40~50% 短縮され、パイプライン 1 つあたり 4,100 ドル、ETL パイプラインにリソースを費やしている一般的な組織では 225,000 ドルの節約になります。

ETL プロセスを介して 1 つのデータベースから別のデータベースにデータを移動する必要がなくなるため、ストレージ コストが削減されます。ETL パイプラインから冗長データが作成されないため、ストレージと準備のコストを 30 ~ 40% 削減できます。

コスト削減

この新しいパラダイムは、データ製品を活用してデータを分析プラットフォームに配信することで、データ パイプラインと比較して、データ製品の作成に必要な労力とコストを削減します。作成にかかる時間が短く、必要なスキル セットも安価です。データ製品の作成には約 24 時間かかり、これは基本的な ETL パイプラインを作成する場合よりも 70% 短くなります。また、作業はデータ エンジニアではなくデータ アナリストが行うことができます。米国のデータ アナリストの平均給与は 77,000 ドル、または総 FTE コストは 100,000 ドルです。このコストは、データ エンジニアの場合は 1 時間あたり 50 ドル、データ アナリストの場合は 96 ドルです。これらの見積もりに基づいて計算すると、1 つのデータ製品を作成するコストは 1,200 ドルであるのに対し、単一のシンプルなデータ パイプラインの場合は 7,600 ドルになります。

新しいデータ プロダクト アプローチにより、データ ストレージの需要は減りますが、その代わりにデータにリアルタイムでアクセスすると、ネットワークとデータベースの処理コストが増加します。トレードオフはありますが、ネットワーク コストは、役に立たない未使用のデータを保管することで発生するストレージ コストとは異なり、分析のために貴重なデータが配信される場合にのみ発生します。

データ ガバナンスの自動化の進歩は、今日のデータ管理環境において大幅なコスト削減ももたらします。自動化されたガバナンスには、データ分類、アクセス制御、メタデータ管理、およびデータ リネージ追跡の自動化が含まれます。データ ガバナンス ソリューションにより、組織はアルゴリズムとワークフローを活用して、データ ポリシーの適用を自動化し、データ使用状況を監視し、データ品質の問題が問題になる前に対処することができます。Informaticaは、自動化されたガバナンス ソリューションを使用することで組織が 475,000 ~ 712,000 ドルを節約できると見積もっています。

通常、これらのソリューションはデータ パイプラインにボルトで固定されたスタンドアロン パッケージであり、25 ユーザーあたり年間約 20,000 ドルのコストがかかります。データ プロダクト プラットフォーム アプローチでは、ガバナンスがプロセスの中心に置かれ、プラットフォームのコストに含まれています。

データ製品によって実現される経済

通常、ETL パイプラインは特定のユースケース向けに構築され、パイプラインが提供するメリットがパイプライン構築コストを上回ることが求められるため、その価値は比較的よく理解され、固定されています。データ プロダクトの適応性により、その価値はよりスケーラブルになります。標準プラットフォーム上に構築されたデータ プロダクトを使用すると、複数のデータ プロダクトを簡単に組み合わせて新しいデータ プロダクトを作成できます。また、特定のデータ プロダクトは特定のユースケース向けである場合もありますが、別のアプリケーションで価値を追加する別の機会に簡単に適応できます。

この適応性により、データ製品の価値は高まり、元の開発者が想定していなかった新しいユースケースに対応できるようになります。価値が高まり、データ製品の作成コストが横ばいになると、その投資収益率は高まります。これは、データ製品がコストを削減して新しい洞察と価値を提供するのに役立つもう 1 つの方法です。

データ プロダクト戦略によってコストが削減され、より適切な意思決定と AI トレーニングが可能になる方法は数多くあります。データ プロダクト戦略はコスト削減に役立ちますが、実際のメリットは俊敏性と競争力の向上に結びついています。このメリットは複合的で定量化できませんが、非常に現実的です。

今すぐデモをリクエストしてください!

Take the leap from data to AI