Revolucionando a análise empresarial: Reduzindo custos com produtos de dados

À medida que a demanda por dados cresce, obter acesso aos melhores dados para dar suporte à tomada de decisões orientada por dados está se tornando uma despesa significativa. Os métodos para mover e acessar dados desenvolvidos antes da proliferação da computação e do armazenamento na nuvem, agora lutam para escalar eficientemente para acompanhar.

As tecnologias de acesso a dados legados não foram projetadas para lidar com a capacidade de estar sempre conectado e em tempo real da nuvem. Antes da nuvem, os dados tinham que ser armazenados perto do aplicativo para serem analisados. Mesmo com a natureza em tempo real da nuvem, a maneira fundamental como os dados são movidos, mesclados e preparados para análise não mudou significativamente. Essa falta de adaptabilidade dificulta a velocidade da análise e ignora oportunidades de reduzir os custos de infraestrutura e engenharia de dados.

Na análise a seguir, consideraremos os custos de acesso a dados da maneira tradicional usando ETL (Extract, Transform, Load) e os compararemos com abordagens inovadoras que usam dados federados que aproveitam os poderosos recursos da nuvem.

Custos de ETL

Calcular o custo exato da criação de pipelines ETL é difícil, mas podemos estimar esses custos avaliando dados disponíveis publicamente e fazendo algumas suposições.

Construindo um pipeline ETL do zero

Construir um pipeline ETL requer um investimento significativo de tempo e recursos. Embora vários recursos sejam necessários para criar um pipeline ETL do zero, um engenheiro de dados executa a maior parte do trabalho. Este profissional altamente qualificado programa manualmente os scripts para extrair dados, transformá-los para análise e carregá-los no banco de dados de destino. De acordo com o Glassdoor, o salário médio de um engenheiro de dados nos EUA excede US$ 150.000 por ano; se você considerar o custo total de FTE de benefícios e despesas, isso custa US$ 195.000 por ano ou US$ 95 por hora.

As estimativas mostram que criar um pipeline ETL rudimentar leva de uma a três semanas. Suponha que assumamos que o esforço médio é de 80 horas para construir um pipeline ETL, o que equivale a US$ 7.600 por pipeline. Além disso, esses pipelines exigem manutenção, o que pode exigir 20% do esforço original a cada ano ou US$ 1.520 adicionais anualmente. Pipelines ETL mais complexos podem levar meses ou até anos para serem construídos, custando centenas de milhares de dólares. Simplesmente construir e testar um conector de dados pode levar seis semanas e meia.

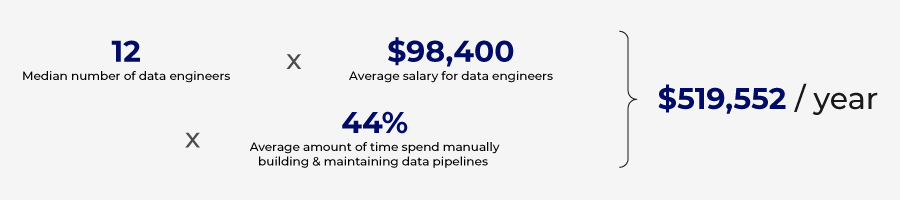

Uma pesquisa conduzida pela Wakefield Research estimou que as organizações gastam US$ 520.000 anualmente para construir e manter pipelines de dados.

Plataforma ETL sem código

Codificar e gerenciar pipelines ETL do zero pode ser caro, mas há ferramentas que podem simplificar o processo e automatizar alguns dos requisitos de codificação. Pipelines ETL menos complexos podem ser construídos usando plataformas sem código.

Essas plataformas alavancam automação e IA para reduzir o tempo e o conjunto de habilidades necessárias para construir pipelines ETL. Aproveitando algumas das ferramentas disponíveis atualmente, os pipelines ETL podem ser criados em apenas três dias.

Embora essas plataformas possam reduzir o requisito de recursos para construir pipelines manualmente, elas têm um custo. Normalmente, essas soluções são baseadas no volume de dados e no número de bancos de dados conectados à plataforma. Para corporações maiores, esses custos aumentam rapidamente, e muitos casos de uso de ponta podem não ser suportados pela solução sem código.

O número de pipelines crescerá à medida que o custo de construção de pipelines ETL com soluções no-code for reduzido significativamente. Essa proliferação de pipelines ETL cria um novo problema: duplicação de dados e aumento nos custos de armazenamento.

Custos de armazenamento

Estratégias de armazenamento vêm em várias configurações e arquiteturas, tornando estimativas precisas de armazenamento bastante complexas. Mas, com base em dados disponíveis publicamente, podemos quantificar os custos associados ao armazenamento e gerenciamento de dados duplicados criados por estratégias de ETL.

Cada vez que um conjunto de dados é extraído de um sistema e carregado em outro, um conjunto de dados duplicado é criado, o qual precisa ser armazenado. Quanto mais pipelines e solicitações de dados, mais conjuntos de dados duplicados são criados, aumentando os custos de armazenamento.

O crescimento do big data e a movimentação prolífica de dados levaram a um aumento de dados redundantes, desatualizados e triviais (ROT) mantidos em armazenamentos de dados. O Statista relata que 8% de todos os dados mantidos por empresas são originais e 91% são replicados. A Veritas Technologies executou um projeto de pesquisa semelhante e descobriu que 16% dos dados são críticos para os negócios, 30% são Redundant Obsolete Trivial (ROT) e 54% são dados obscuros, onde o valor dos dados é desconhecido. Ambos os estudos chegam a uma conclusão semelhante: uma quantidade esmagadora de dados inúteis é mantida por empresas, levando a quantidades significativas de desperdício de recursos no armazenamento do que são dados inúteis.

Se você considerar que o Google Cloud cobra US$ 0,02 por GB por mês para armazenamento em nuvem, isso dá US$ 20 por terabyte e US$ 20.000 por petabyte. De acordo com a Veritas Technologies, a organização média gasta US$ 650.000 anualmente para armazenar dados não críticos.

Vários fatores estão impulsionando o crescimento do ROT, com a manutenção de silos de dados sendo um driver significativo. Com cada função de negócios mantendo seu próprio banco de dados para dar suporte a cada operação, levando a conjuntos de dados comuns sendo repetidos em muitos desses bancos de dados, desperdiçando recursos de armazenamento.

Dados ruins causados por ROT

Custo da Governança

Armazenar ROT não só tem implicações de custo de armazenamento, mas também aumenta o risco. Múltiplas cópias do mesmo conjunto de dados levam a fontes conflitantes de verdade, e vários formatos de dados levam à confusão.

Para evitar dados de baixa qualidade, políticas efetivas de governança de dados devem ser implementadas. Em 2021, a Gartner estimou que dados de baixa qualidade custam às organizações uma média de US$ 12,9 milhões anualmente.

Os processos tradicionais de governança de dados manuais não são mais suficientes, e investimentos em ferramentas e estratégias automatizadas de governança de dados são necessários. A verificação manual de relatórios e a configuração de regras personalizadas consomem tempo. Implementar essas políticas, regras e supervisão de forma independente para cada pipeline ETL requer atenção cuidadosa e investimento de tempo.

Investir na prevenção de dados ruins é dinheiro bem gasto. Se custa um dólar para prevenir dados ruins, custará US$ 10 para consertá-los e US$ 100 para falhas. OData Warehousing Institute diz que dados ruins custam às empresas US$ 600 bilhões anualmente.

Dados redundantes também apresentam riscos de privacidade. Muitos dos dados que são replicados em silos de dados incluem dados PII (informações pessoalmente identificáveis). Essa abordagem aumenta a probabilidade de uma violação de dados.

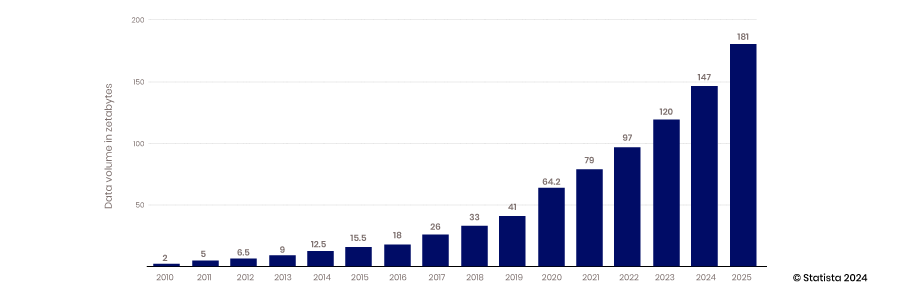

Os desafios só aumentarão

O crescimento exponencial contínuo da coleta e armazenamento de dados só vai exacerbar os problemas em torno de dados duplicados criados por estratégias ineficientes de integração e gerenciamento de dados. A Statista estima que até 2025, 181 zettabytes serão criados, consumidos, copiados e capturados.

Custos suaves

Com o tempo necessário para desenvolver pipelines ETL do zero ou usando plataformas sem código, o acesso aos dados não é tão ágil quanto poderia ser. Oportunidades são perdidas quando analistas e tomadores de decisão não conseguem acessar dados de qualidade rapidamente. Esses custos de oportunidade são difíceis de quantificar, mas são muito reais. Com o número de decisões tomadas em uma organização, aumentar o tempo para obter insights, mesmo que marginalmente, é significativo. Ao otimizar a tomada de decisões em uma organização, a economia de custos de oportunidade aumenta à medida que boas decisões levam a decisões e opções ainda melhores.

Novo Paradigma

Uma nova abordagem ou paradigma de acesso a dados está surgindo que reduzirá os custos de acesso e gerenciamento de dados. Essa abordagem se afasta do ETL e se concentra na governança central, segurança e acesso em torno de produtos de dados. (Para se aprofundar no Novo Paradigma de Dados, certifique-se de ler esta postagem do blog)

Essa nova abordagem fornece acesso aos dados sem precisar movê-los ou replicá-los. Essa estratégia também aproveita produtos de dados reutilizáveis que eliminam a necessidade de criar pipelines ETL para cada caso de uso. Essa mudança pode resultar em economia de tempo de 40-50% para provisionar dados para autoatendimento, totalizando uma economia de US$ 4.100 por pipeline individual, ou US$ 225.000 para a organização típica que gasta recursos em pipelines ETL.

Como a necessidade de mover dados de um banco de dados para outro por meio de um processo ETL é eliminada, os custos de armazenamento são reduzidos. Sem dados redundantes criados a partir de pipelines ETL, os custos de armazenamento e preparação podem ser reduzidos em 30-40%.

Redução de custos

Este novo paradigma alavanca produtos de dados para entregar dados para plataformas analíticas, reduzindo assim o esforço e os custos necessários para criar esses produtos de dados em comparação com pipelines de dados. Eles levam menos tempo para criar e exigem conjuntos de habilidades menos dispendiosos. Leva cerca de 24 horas para criar um produto de dados, o que é 70% menos do que criar um pipeline ETL rudimentar. Além disso, o trabalho pode ser conduzido por um analista de dados em vez de um engenheiro de dados. Os salários para analistas de dados nos EUA são em média US$ 77.000 ou um custo total de FTE de US$ 100.000. Esse custo equivale a US$ 50 por hora contra US$ 96 para um engenheiro de dados. Fazendo as contas com base nessas estimativas, o custo para criar um produto de dados é de US$ 1.200, em comparação com US$ 7.600 para um único pipeline de dados simples.

A nova abordagem de produto de dados reduz a demanda por armazenamento de dados, mas o acesso em tempo real aos dados em seu lugar aumenta os custos de processamento de rede e banco de dados. Embora haja uma compensação, os custos de rede são incorridos apenas quando dados valiosos são entregues para análise, diferentemente dos custos de armazenamento que são incorridos ao armazenar dados inúteis e não utilizados.

O avanço na automação da governança de dados também gera economias significativas de custos no cenário atual de gerenciamento de dados. A governança automatizada inclui automatizar a classificação de dados, controle de acesso, gerenciamento de metadados e rastreamento de linhagem de dados. As soluções de governança de dados permitem que as organizações aproveitem algoritmos e fluxos de trabalho para automatizar a aplicação de políticas de dados, monitorar o uso de dados e abordar problemas de qualidade de dados antes que se tornem um problema. A Informatica estima que as organizações podem economizar de US$ 475.000 a US$ 712.000 usando soluções de governança automatizadas.

Normalmente, essas soluções são pacotes autônomos parafusados em seus pipelines de dados, custando cerca de US$ 20.000 por ano para 25 usuários. A abordagem da plataforma de produtos de dados coloca a governança no centro do processo e está incluída no custo da plataforma.

Economias impulsionadas por produtos de dados

Normalmente, os pipelines ETL são construídos para um caso de uso específico, com os benefícios que eles fornecem necessários para superar os custos para construí-los, tornando seu valor relativamente bem compreendido e estático. A adaptabilidade dos produtos de dados torna seu valor mais escalável. Com produtos de dados construídos em uma plataforma padrão, vários produtos de dados podem ser facilmente combinados para criar novos produtos de dados. Além disso, um produto de dados específico pode ser destinado a um caso de uso particular, mas pode ser facilmente adaptado a outra oportunidade para adicionar valor em um aplicativo separado.

Essa adaptabilidade permite que os produtos de dados aumentem em valor, pois podem abordar novos casos de uso que o desenvolvedor original pode não ter previsto. À medida que o valor aumenta e o custo para criar esse produto de dados permanece estagnado, o retorno sobre esse investimento cresce. Essa é outra maneira pela qual os produtos de dados estão ajudando a reduzir custos para fornecer novos insights e valor.

Há inúmeras maneiras pelas quais uma estratégia de produto de dados reduz custos, permitindo melhor tomada de decisão e treinamento de IA. Embora a estratégia de produto de dados ajude a reduzir custos, o benefício real está vinculado ao aumento da agilidade e competitividade. Esse benefício é composto e não quantificável, mas muito real.

Solicite uma demonstração HOJE!

Take the leap from data to AI