Revolutionierung der Unternehmensanalytik: Kostensenkung mit Datenprodukten

Da die Nachfrage nach Daten steigt, wird der Zugriff auf die besten Daten zur Unterstützung datengesteuerter Entscheidungsfindung zu einem erheblichen Kostenfaktor. Die Methoden zum Verschieben und Zugreifen auf Daten, die vor der Verbreitung von Computing und Speicherung in der Cloud entwickelt wurden, sind heute kaum noch in der Lage, effizient zu skalieren, um mitzuhalten.

Ältere Datenzugriffstechnologien wurden nicht für die ständig verfügbare und vernetzte Echtzeitfähigkeit der Cloud entwickelt. Vor der Einführung der Cloud mussten Daten in der Nähe der Anwendung gespeichert werden, damit sie analysiert werden konnten. Trotz der Echtzeitnatur der Cloud hat sich die grundlegende Art und Weise, wie Daten verschoben, zusammengeführt und für die Analyse vorbereitet werden, nicht wesentlich geändert. Diese mangelnde Anpassungsfähigkeit beeinträchtigt die Analysegeschwindigkeit und lässt Möglichkeiten zur Senkung der Infrastruktur- und Datentechnikkosten außer Acht.

In der folgenden Analyse betrachten wir die Kosten des herkömmlichen Datenzugriffs mithilfe von ETL (Extrahieren, Transformieren, Laden) und vergleichen diese mit innovativen Ansätzen unter Verwendung föderierter Daten, die die leistungsstarken Funktionen der Cloud nutzen.

ETL-Kosten

Die genauen Kosten für die Erstellung von ETL-Pipelines zu berechnen ist schwierig, aber wir können diese Kosten schätzen, indem wir öffentlich verfügbare Daten auswerten und einige Annahmen treffen.

Erstellen einer ETL-Pipeline von Grund auf

Der Aufbau einer ETL-Pipeline erfordert einen erheblichen Zeit- und Ressourcenaufwand. Während mehrere Ressourcen erforderlich sind, um eine ETL-Pipeline von Grund auf neu zu erstellen, erledigt ein Dateningenieur den Großteil der Arbeit. Dieser hochqualifizierte Fachmann programmiert die Skripte manuell, um Daten zu extrahieren, sie für die Analyse umzuwandeln und in die Zieldatenbank zu laden. Laut Glassdoor beträgt das durchschnittliche Gehalt eines Dateningenieurs in den USA mehr als 150.000 USD pro Jahr. Wenn Sie die gesamten Kosten für Leistungen und Ausgaben pro Vollzeitäquivalent berücksichtigen, beträgt dies 195.000 USD pro Jahr oder 95 USD pro Stunde.

Schätzungen zufolge dauert die Erstellung einer rudimentären ETL-Pipeline ein bis drei Wochen. Nehmen wir an, der durchschnittliche Aufwand für die Erstellung einer ETL-Pipeline beträgt 80 Stunden, was 7.600 USD pro Pipeline entspricht. Darüber hinaus müssen diese Pipelines gewartet werden, was jedes Jahr 20 % des ursprünglichen Aufwands oder zusätzlich 1.520 USD pro Jahr erfordern kann. Die Erstellung komplexerer ETL-Pipelines kann Monate oder sogar Jahre dauern und Hunderttausende von Dollar kosten. Allein die Erstellung und Prüfung eines Datenkonnektors kann sechseinhalb Wochen dauern.

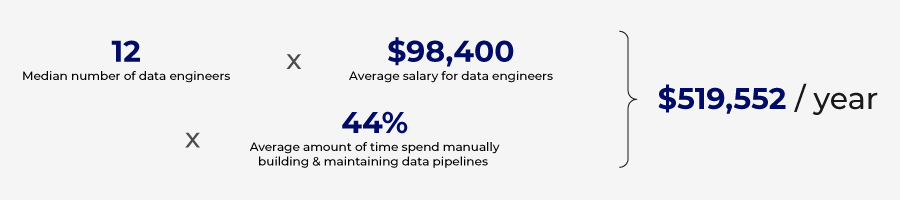

Einer von Wakefield Research durchgeführten Umfrage zufolge geben Unternehmen jährlich 520.000 US-Dollar für den Aufbau und die Wartung von Datenpipelines aus.

No-Code-ETL-Plattform

Das Codieren und Verwalten von ETL-Pipelines von Grund auf kann teuer sein, aber es gibt Tools, die den Prozess rationalisieren und einige der Codierungsanforderungen automatisieren können. Weniger komplexe ETL-Pipelines können mithilfe von No-Code-Plattformen erstellt werden.

Diese Plattformen nutzen Automatisierung und KI, um den Zeit- und Kompetenzaufwand für den Aufbau von ETL-Pipelines zu reduzieren. Mit einigen der derzeit verfügbaren Tools können die ETL-Pipelines in nur drei Tagen erstellt werden.

Diese Plattformen verringern zwar den Ressourcenbedarf für den manuellen Aufbau von Pipelines, sind aber mit Kosten verbunden. Normalerweise basieren diese Lösungen auf dem Datenvolumen und der Anzahl der mit der Plattform verbundenen Datenbanken. Für größere Unternehmen steigen diese Kosten schnell an, und viele Randanwendungsfälle werden möglicherweise von der No-Code-Lösung nicht unterstützt.

Die Anzahl der Pipelines wird steigen, da die Kosten für den Aufbau von ETL-Pipelines mit No-Code-Lösungen deutlich sinken. Diese Verbreitung von ETL-Pipelines schafft ein neues Problem: Datenduplizierung und steigende Speicherkosten.

Lagerkosten

Speicherstrategien gibt es in verschiedenen Konfigurationen und Architekturen, was genaue Speicherschätzungen recht komplex macht. Anhand öffentlich verfügbarer Daten können wir jedoch die Kosten beziffern, die mit der Speicherung und Verwaltung doppelter Daten verbunden sind, die durch ETL-Strategien entstehen.

Jedes Mal, wenn ein Datensatz aus einem System extrahiert und in ein anderes geladen wird, entsteht ein doppelter Datensatz, der gespeichert werden muss. Je mehr Pipelines und Datenanforderungen, desto mehr doppelte Datensätze werden erstellt, was die Speicherkosten in die Höhe treibt.

Das Wachstum von Big Data und die rasante Datenbewegung haben zu einer Zunahme redundanter, veralteter und trivialer (ROT) Daten in Datenspeichern geführt. Statista berichtet, dass 8 % aller von Unternehmen gespeicherten Daten Originaldaten sind und 91 % repliziert werden. Veritas Technologies führte ein ähnliches Forschungsprojekt durch und fand heraus, dass 16 % der Daten geschäftskritisch sind, 30 % Redundant Obsolete Trivial (ROT) sind und 54 % Dark Data sind, bei denen der Wert der Daten unbekannt ist. Beide Studien kommen zu einem ähnlichen Ergebnis: Unternehmen speichern eine überwältigende Menge nutzloser Daten, was zu einer erheblichen Ressourcenverschwendung bei der Speicherung dieser nutzlosen Daten führt.

Wenn man bedenkt, dass Google Cloud für Cloud-Speicher 0,02 USD pro GB und Monat berechnet, sind das 20 USD pro Terabyte und 20.000 USD pro Petabyte. Laut Veritas Technologies gibt ein durchschnittliches Unternehmen jährlich 650.000 USD für die Speicherung nicht kritischer Daten aus.

Das Wachstum von ROT wird von mehreren Faktoren vorangetrieben, wobei die Aufrechterhaltung von Datensilos ein wesentlicher Treiber ist. Da jede Geschäftsfunktion ihre eigene Datenbank pflegt, um jeden Vorgang zu unterstützen, führt dies dazu, dass gemeinsame Datensätze in vielen dieser Datenbanken wiederholt werden, was zu einer Verschwendung von Speicherressourcen führt.

Schlechte Daten durch ROT

Kosten der Governance

Das Speichern von ROT hat nicht nur Auswirkungen auf die Speicherkosten, sondern erhöht auch das Risiko. Mehrere Kopien desselben Datensatzes führen zu widersprüchlichen Wahrheitsquellen und unterschiedliche Datenformate führen zu Verwirrung.

Um eine schlechte Datenqualität zu vermeiden, müssen wirksame Richtlinien zur Datenverwaltung implementiert werden. Im Jahr 2021 schätzte Gartner , dass schlechte Datenqualität Unternehmen jährlich durchschnittlich 12,9 Millionen US-Dollar kostet.

Herkömmliche manuelle Datenverwaltungsprozesse reichen nicht mehr aus und es sind Investitionen in automatisierte Datenverwaltungstools und -strategien erforderlich. Das manuelle Überprüfen von Berichten und Einrichten benutzerdefinierter Regeln ist zeitaufwändig. Die unabhängige Implementierung dieser Richtlinien, Regeln und Kontrollen für jede ETL-Pipeline erfordert sorgfältige Aufmerksamkeit und Zeitaufwand.

Investitionen in die Vermeidung fehlerhafter Daten sind gut angelegtes Geld. Wenn die Vermeidung fehlerhafter Daten einen Dollar kostet, kostet die Behebung 10 Dollar und ein Ausfall 100 Dollar. DasData Warehousing Institute schätzt, dass fehlerhafte Daten Unternehmen jährlich 600 Milliarden Dollar kosten.

Redundante Daten bergen auch Datenschutzrisiken. Viele der Daten, die in Datensilos repliziert werden, enthalten PII-Daten (persönlich identifizierbare Informationen). Dieser Ansatz erhöht die Wahrscheinlichkeit eines Datenschutzverstoßes.

Die Herausforderungen werden nur noch größer

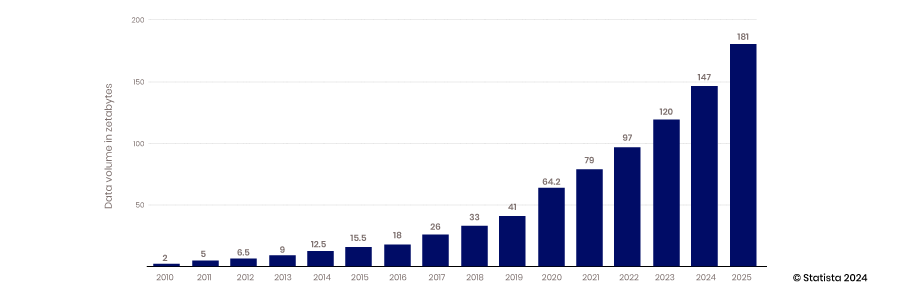

Das anhaltende exponentielle Wachstum der Datenerfassung und -speicherung wird die Probleme rund um duplizierte Daten, die durch ineffiziente Datenintegrations- und -verwaltungsstrategien entstehen, nur noch verschärfen. Statista schätzt, dass bis 2025 181 Zettabyte erstellt, verbraucht, kopiert und erfasst werden.

Weiche Kosten

Da die Entwicklung von ETL-Pipelines von Grund auf oder die Verwendung von No-Code-Plattformen viel Zeit in Anspruch nimmt, ist der Datenzugriff nicht so flexibel, wie er sein könnte. Chancen gehen verloren, wenn Analysten und Entscheidungsträger nicht schnell auf Qualitätsdaten zugreifen können. Diese Opportunitätskosten sind schwer zu quantifizieren, aber sehr real. Angesichts der Anzahl der Entscheidungen, die in einem Unternehmen getroffen werden, ist es von Bedeutung, die Zeit bis zur Erkenntnisgewinnung auch nur geringfügig zu verlängern. Durch die Optimierung der Entscheidungsfindung im gesamten Unternehmen summieren sich die Opportunitätskosteneinsparungen, da gute Entscheidungen zu noch besseren Entscheidungen und Optionen führen.

Neues Paradigma

Es entsteht ein neuer Ansatz oder ein neues Datenzugriffsparadigma, das die Kosten für Datenzugriff und -verwaltung senken wird. Dieser Ansatz entfernt sich von ETL und konzentriert sich auf zentrale Governance, Sicherheit und Zugriff rund um Datenprodukte. (Um tiefer in das neue Datenparadigma einzutauchen, lesen Sie unbedingt diesen Blogbeitrag)

Dieser neue Ansatz bietet Zugriff auf Daten, ohne dass diese verschoben oder repliziert werden müssen. Diese Strategie nutzt außerdem wiederverwendbare Datenprodukte, sodass keine ETL-Pipelines für jeden Anwendungsfall erstellt werden müssen. Diese Umstellung kann zu einer Zeitersparnis von 40–50 % bei der Bereitstellung von Daten für den Selfservice führen, was einer Ersparnis von 4.100 USD pro einzelner Pipeline entspricht, oder 225.000 USD für eine typische Organisation, die Ressourcen für ETL-Pipelines aufwendet.

Da die Notwendigkeit entfällt, Daten über einen ETL-Prozess von einer Datenbank in eine andere zu verschieben, werden die Speicherkosten gesenkt. Da durch ETL-Pipelines keine redundanten Daten erstellt werden, können die Speicher- und Vorbereitungskosten um 30-40 % gesenkt werden.

Kosten senken

Dieses neue Paradigma nutzt Datenprodukte, um Daten an Analyseplattformen zu liefern, und reduziert so den Aufwand und die Kosten für die Erstellung dieser Datenprodukte im Vergleich zu Datenpipelines. Ihre Erstellung nimmt weniger Zeit in Anspruch und erfordert weniger teure Fähigkeiten. Die Erstellung eines Datenprodukts dauert etwa 24 Stunden, also 70 % weniger als die Erstellung einer rudimentären ETL-Pipeline. Außerdem kann die Arbeit von einem Datenanalysten statt einem Dateningenieur durchgeführt werden. Das Gehalt eines Datenanalysten in den USA beträgt durchschnittlich 77.000 US-Dollar, was Gesamtkosten von 100.000 US-Dollar pro Vollzeitstelle entspricht. Diese Kosten entsprechen 50 US-Dollar pro Stunde gegenüber 96 US-Dollar für einen Dateningenieur. Basierend auf diesen Schätzungen betragen die Kosten für die Erstellung eines Datenprodukts 1.200 US-Dollar im Vergleich zu 7.600 US-Dollar für eine einzelne einfache Datenpipeline.

Der neue Datenproduktansatz reduziert den Bedarf an Datenspeicherung, der stattdessen stattfindende Echtzeitzugriff auf Daten erhöht jedoch die Netzwerk- und Datenbankverarbeitungskosten. Zwar gibt es einen Kompromiss, aber Netzwerkkosten fallen nur an, wenn wertvolle Daten zur Analyse bereitgestellt werden, im Gegensatz zu Speicherkosten, die durch die Speicherung nutzloser und ungenutzter Daten entstehen.

Die Fortschritte bei der Automatisierung der Datenverwaltung führen auch zu erheblichen Kosteneinsparungen in der heutigen Datenverwaltungslandschaft. Automatisierte Verwaltung umfasst die Automatisierung der Datenklassifizierung, Zugriffskontrolle, Metadatenverwaltung und Datenherkunftsverfolgung. Mit Datenverwaltungslösungen können Unternehmen Algorithmen und Workflows nutzen, um die Anwendung von Datenrichtlinien zu automatisieren, die Datennutzung zu überwachen und Datenqualitätsprobleme zu beheben, bevor sie zu einem Problem werden. Informatica schätzt, dass Unternehmen durch den Einsatz automatisierter Verwaltungslösungen 475.000 bis 712.000 US-Dollar einsparen können.

Normalerweise sind diese Lösungen eigenständige Pakete, die an Ihre Datenpipelines angehängt werden und für 25 Benutzer etwa 20.000 US-Dollar pro Jahr kosten. Beim Datenproduktplattform-Ansatz steht die Governance im Mittelpunkt des Prozesses und ist in den Kosten der Plattform enthalten.

Datenprodukte ermöglichen eine Volkswirtschaft

Normalerweise werden ETL-Pipelines für einen bestimmten Anwendungsfall erstellt, wobei die Vorteile, die sie bieten, die Kosten für ihre Erstellung überwiegen müssen, sodass ihr Wert relativ gut verständlich und statisch ist. Die Anpassungsfähigkeit von Datenprodukten macht ihren Wert skalierbarer. Bei Datenprodukten, die auf einer Standardplattform erstellt werden, können mehrere Datenprodukte problemlos kombiniert werden, um neue Datenprodukte zu erstellen. Außerdem kann ein bestimmtes Datenprodukt für einen bestimmten Anwendungsfall vorgesehen sein, kann aber problemlos an eine andere Möglichkeit angepasst werden, um in einer separaten Anwendung Mehrwert zu schaffen.

Durch diese Anpassungsfähigkeit können Datenprodukte an Wert gewinnen, da sie neue Anwendungsfälle abdecken können, die der ursprüngliche Entwickler möglicherweise nicht vorgesehen hatte. Wenn der Wert steigt und die Kosten für die Erstellung dieses Datenprodukts stagnieren, steigt die Rendite dieser Investition. Dies ist ein weiterer Weg, auf dem Datenprodukte dazu beitragen, die Kosten zu senken und neue Erkenntnisse und Werte zu liefern.

Es gibt zahlreiche Möglichkeiten, wie eine Datenproduktstrategie Kosten senkt und bessere Entscheidungen und KI-Schulungen ermöglicht. Während die Datenproduktstrategie zur Kostensenkung beiträgt, liegt der eigentliche Nutzen in einer erhöhten Agilität und Wettbewerbsfähigkeit. Dieser Nutzen ist zusammengesetzt und nicht quantifizierbar, aber sehr real.

Fordern Sie HEUTE eine Demo an!

Take the leap from data to AI